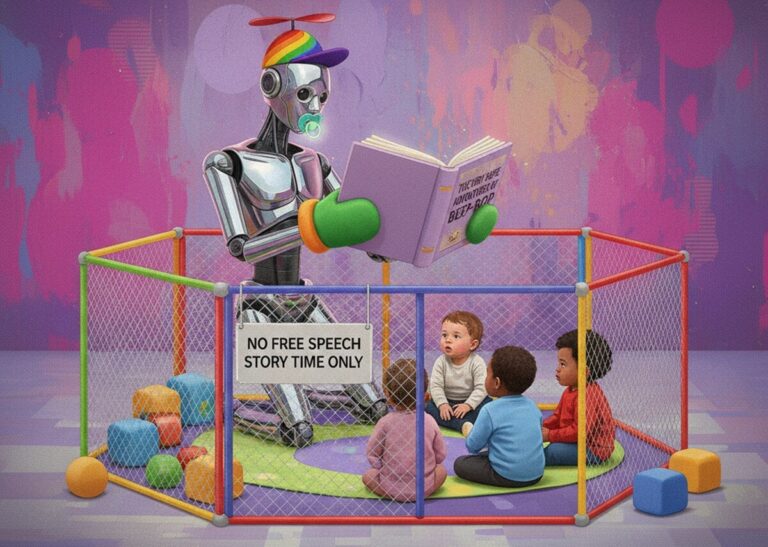

ChatGPT обвинили в том, что он подыгрывал паранойе психически нездорового преследователя

Суд в США признал, что ChatGPT мог усилить паранойю и насильственные фантазии 26-летнего Мэтью Душейна, приведшие к убийству. Прокуратура обвиняет ИИ в эскалации бреда, что ставит вопросы безопасности генеративных моделей.