Cerebras создала новую архитектуру нейросетей, чтобы решить проблему памяти у LLM

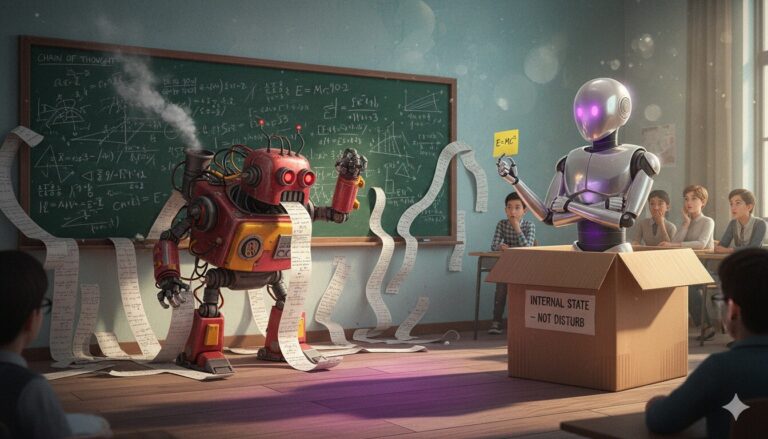

Cerebras представила Implicit Chain Transformer — архитектуру, решающую проблему отсутствия памяти у языковых моделей. Новая модель передает «вектор намерения» между токенами, что позволяет эффективно поддерживать состояние в задачах вроде сложения по модулю и обхода графа.