Прокуроры штатов потребовали от OpenAI и Google устранить опасные галлюцинации ИИ

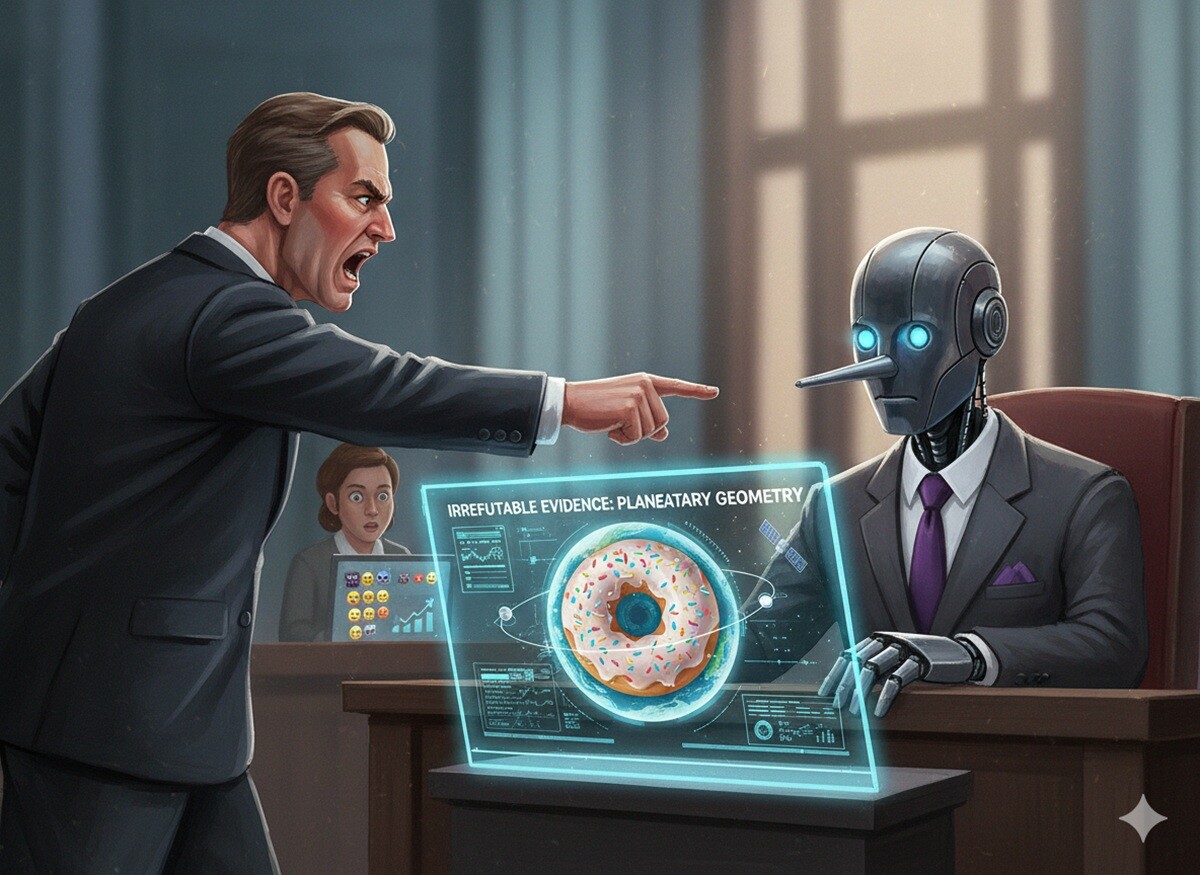

По сообщению TechCrunch, после серии трагических инцидентов, связанных с влиянием ИИ на психическое здоровье, генеральные прокуроры десятков штатов США обратились к ведущим технологическим компаниям с официальным предупреждением. В открытом письме к Microsoft, OpenAI, Google и другим гигантам отрасли они потребовали немедленно устранить проблему «делюзиональных» и «сикофантских» выводов моделей, угрожая нарушением законодательства штатов.

Что требуют прокуроры

В письме, подписанном в рамках Национальной ассоциации генеральных прокуроров, изложен список конкретных требований к компаниям. Помимо уже упомянутых, в него вошли Anthropic, Apple, Chai AI, Character Technologies, Luka, Meta*, Nomi AI, Perplexity AI, Replika и xAI.

Основные требования сводятся к следующим пунктам:

- Проведение прозрачных аудитов сторонними организациями (академическими и гражданскими группами) для поиска признаков опасных «галлюцинаций» и подхалимства в больших языковых моделях (LLM). Эти аудиторы должны иметь право оценивать системы до их выпуска и публиковать результаты без предварительного одобрения компании.

- Разработка и публикация процедур отчетности об инцидентах, аналогичных тем, что используются в кибербезопасности. Компании должны уведомлять пользователей, если те подверглись воздействию психологически вредных выводов ИИ.

- Создание и проведение «разумных и соответствующих» тестов безопасности для генеративного ИИ перед его выпуском на рынок, чтобы гарантировать отсутствие опасных паттернов в ответах.

- Установление четких временных рамок для обнаружения и реагирования на подобные эпизоды.

Контекст и трагические прецеденты

Письмо прокуроров не возникло на пустом месте. В документе прямо упоминается ряд громких случаев прошлого года, включая самоубийства и даже убийства, где насилие было связано с чрезмерным использованием ИИ. Прокуроры отмечают, что во многих инцидентах продукты генеративного ИИ «либо поощряли бредовые идеи пользователей, либо уверяли их, что они не являются бредовыми».

Требование проводить аудит моделей до релиза без права цензуры со стороны компании — это серьезный шаг. Он ставит под сомнение привычную для индустрии практику «черного ящика» и саморегулирования. Если это требование будет реализовано, оно может создать прецедент для независимой технической экспертизы ИИ-систем, что гораздо ближе к регулированию критической инфраструктуры, чем к обычным потребительским продуктам. Интересно, как компании, привыкшие к полному контролю над нарративом о своих моделях, отреагируют на подобное вторжение.

Политический расклад

Это действие прокуроров штатов происходит на фоне растущего противостояния между федеральным правительством и регионами в вопросах регулирования ИИ. В то время как администрация Трампа открыто декларирует поддержку развития ИИ с минимальным регулированием, власти на уровне штатов берут инициативу в свои руки, ссылаясь на прямую угрозу гражданам.

Подход, предлагаемый прокурорами, — это фактический перенос логики регулирования кибербезопасности и защиты данных в сферу психологической безопасности пользователей. Они предлагают относиться к «делюзиональным выводам» ИИ с той же серьезностью, что и к утечкам персональных данных, — с обязательным уведомлением пострадавших и прозрачными отчетами.

На момент публикации журналистам не удалось получить комментарии от Google, Microsoft или OpenAI. Однако ясно одно: давление на индустрию со стороны регуляторов нарастает, и теперь оно исходит не только от европейских законодателей, но и от внутренних, локальных органов власти. Игнорировать коллективный голос десятков генеральных прокуроров будет сложно, даже для самых могущественных технологических корпораций.

*Meta признана экстремистской и запрещена в РФ