LiteCoder-Terminal: компактные LLM для командной строки с рекордной эффективностью

На фоне гонки за созданием всё более крупных и прожорливых языковых моделей команда LiteCoder демонстрирует противоположный подход: специализированные, компактные модели, обучаемые на предельно малых наборах данных. Их последняя разработка — семейство моделей LiteCoder-Terminal-Preview, предназначенное для выполнения агентских задач в командной строке. Ключевой результат: модели достигают конкурентоспособной производительности, обучаясь менее чем на 1000 синтетических траекторий. Это вызов распространённому мнению о необходимости миллионов примеров для обучения способных ИИ-агентов.

Что было выпущено

Команда опубликовала несколько ключевых артефактов для сообщества:

- LiteCoder-4b-Terminal-preview: 4-миллиардная параметрическая модель.

- LiteCoder-SFT-Terminal-preview: сам набор данных для тонкой настройки (Supervised Fine-Tuning).

- Исходный код проекта доступен на GitHub.

Конвейер создания данных: синтез вместо сбора

Вместо того чтобы собирать и размечать реальные взаимодействия с терминалом, что является трудоёмким и масштабируемым процессом, исследователи построили полностью синтетический пайплайн. Он состоит из трёх основных этапов.

Генерация задач

На основе таксономии из семи основных областей использования терминала (от ai_ml до version_control) модель используется для «автодополнения» пользовательских запросов, генерируя реалистичные и сложные задачи.

Метод напоминает подход MAGPIE.

Проверка осуществимости

Сгенерированные задачи проходят строгую валидацию с помощью LLM-as-a-Judge. Модель-судья оценивает их по критериям сложности, ясности формулировки и доступности ресурсов, отфильтровывая невыполнимые варианты.

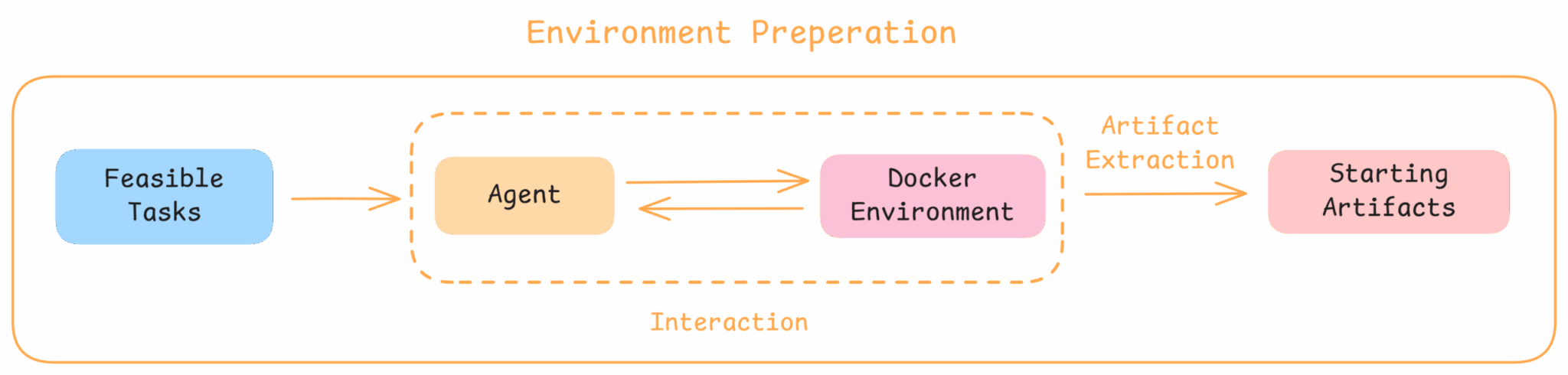

Подготовка среды и генерация траекторий

Для задач, требующих определённого начального состояния (например, репозитория с конфликтом в Git), специальный агент в Docker-контейнере интерактивно создаёт необходимые артефакты.

Финальные траектории выполнения генерируются с помощью фреймворка Harbor и сильных моделей-«учителей», таких как MiniMax-M2, с последующей фильтрацией цикличного поведения.

Идея обучать модель на тысяче примеров, когда конкуренты используют миллионы, выглядит либо гениальной оптимизацией, либо опасным упрощением. Результаты на Terminal Bench, однако, говорят в пользу первого. Это напоминает старую истину: качество данных часто важнее их количества. Особенно впечатляет чувствительность модели к фреймворку агента — она обучена так тесно со своей «средой обитания», что смена инструментария может её сломать. Получается очень способный, но несколько «домашний» питомец.

Результаты на Terminal Bench

Несмотря на скромный размер и крошечный обучающий датасет, модели LiteCoder показывают впечатляющие результаты на специализированном бенчмарке Terminal Bench, обходя более крупные модели общего назначения.

Terminal Bench 1.0:

- LiteCoder-30a3b-Terminal-preview: 18.75%

- LiteCoder-4b-Terminal-preview: 13.75%

- Qwen3-30B-A3B-Instruct: 12.5%

- Qwen3-4B-Instruct: 5.0%

Terminal Bench 2.0 (более сложная версия):

- LiteCoder-30a3b-Terminal-preview: 5.6%

- LiteCoder-4b-Terminal-preview: 3.3%

- Qwen3-32B: 1.9%

- InternLM3-8B-Nex-N1: 0%

- Qwen3-8B: 0%

Ключевые выводы исследователей

Анализ работы успешных моделей выявил несколько важных паттернов:

- Адаптивность к среде: Лучшие модели не слепо следуют заранее составленному плану, а умеют интерпретировать обратную связь системы (stdout/stderr) и динамически менять стратегию.

- Поддержание контекста: Успешные агенты сохраняют связность на протяжении длинных серий взаимодействий, не теряя изначальную цель.

- Зависимость от фреймворка: Обнаружена сильная чувствительность к структуре промптов и определению инструментов. Модели, плотно обученные в рамках одного агентского фреймворка, плохо переносятся на другие. Это подчёркивает важность создания данных, не зависящих от конкретной реализации.

Будущее проекта и команда

В планах команды — расширение разнообразия Docker-сред и учительских моделей для улучшения обобщающей способности, а также внедрение обучения с подкреплением (Reinforcement Learning) специально для многоходовых агентских workflows. Проект ведётся группой исследователей, включающей Сяосюань Пэн (основной вкладчик) и Синью Лу (руководитель проекта). Работа основана на открытых проектах, таких как Harbor, а для обучения используется фреймворк AutoAlign.

По материалам Hugging Face.