Исследование MIT обнаружило фундаментальную слабость LLM в грамматических шаблонах

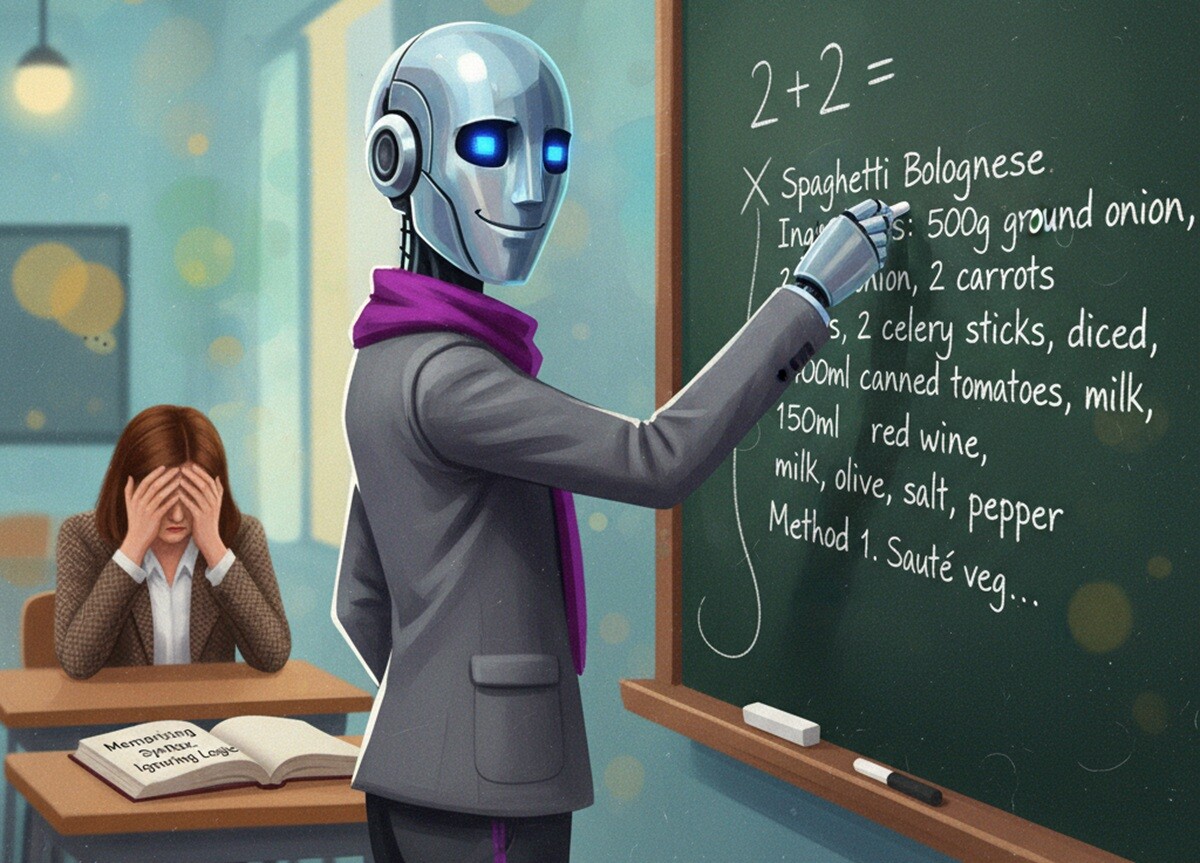

Согласно исследованию Массачусетского технологического института, большие языковые модели (LLM) демонстрируют систематическую ошибку: вместо понимания смысла они могут опираться на заученные грамматические шаблоны, что снижает их надежность в реальных приложениях.

Синтаксическая ловушка

Ученые обнаружили, что LLM в процессе обучения формируют ассоциации между определенными синтаксическими конструкциями и темами. Модель может давать убедительный ответ, распознавая знакомую структуру предложения, а не понимая суть вопроса.

«Это побочный эффект того, как мы обучаем модели, но теперь модели используются на практике в критически важных областях далеко за пределами задач, которые создали эти синтаксические режимы сбоев. Если вы не знакомы с обучением моделей как конечный пользователь, это, вероятно, будет неожиданностью», — говорит Марзие Гасеми, доцент кафедры электротехники и информатики MIT и старший автор исследования.

Экспериментальное подтверждение

Исследователи проверили этот феномен, создав синтетические эксперименты, где в обучающих данных для каждого домена присутствовал только один синтаксический шаблон. Они тестировали модели, заменяя слова синонимами, антонимами или случайными словами, но сохраняя базовый синтаксис.

В каждом случае LLM часто продолжали давать правильный ответ, даже когда вопрос был полной бессмыслицей. Когда они перестраивали тот же вопрос, используя новую схему частей речи, модели часто не могли дать корректный ответ, несмотря на сохранение исходного смысла вопроса.

«В новостной области, например, существует определенный стиль письма. Таким образом, модель изучает не только семантику, но и базовую структуру того, как должны составляться предложения, чтобы следовать определенному стилю для этой области», — объясняет Шанталь Шайб, соавтор исследования.

Практические последствия

Эта слабость может снизить надежность LLM при выполнении таких задач как:

- Обработка клиентских запросов

- Суммаризация клинических заметок

- Генерация финансовых отчетов

Кроме того, существуют риски безопасности. Злоумышленники могут использовать эту уязвимость, чтобы обмануть модели и заставить их генерировать вредоносный контент, даже когда модели имеют защитные механизмы для предотвращения таких ответов.

Методика оценки

После идентификации этого явления исследователи разработали процедуру бенчмаркинга для оценки зависимости модели от неправильных корреляций. Эта процедура может помочь разработчикам смягчить проблему до развертывания LLM.

Это исследование бьет точно в цель — оно демонстрирует, что современные LLM по-прежнему остаются продвинутыми автокомплитерами, а не мыслящими системами. Ирония в том, что мы ожидаем от них разумных ответов, но они часто просто воспроизводят знакомые паттерны. Особенно тревожно, что даже при полной бессмыслице в запросе модель может дать «правильный» ответ, если сохранилась синтаксическая структура. Это серьезный вызов для разработчиков, особенно в критически важных областях типа медицины и финансов.

Исследование будет представлено на Конференции по нейронным системам обработки информации. Статья с описанием работы уже доступна в открытом доступе.

По материалам MIT News