Авторы статей отзывают их из-за рецензентов, которые на самом деле — ИИ

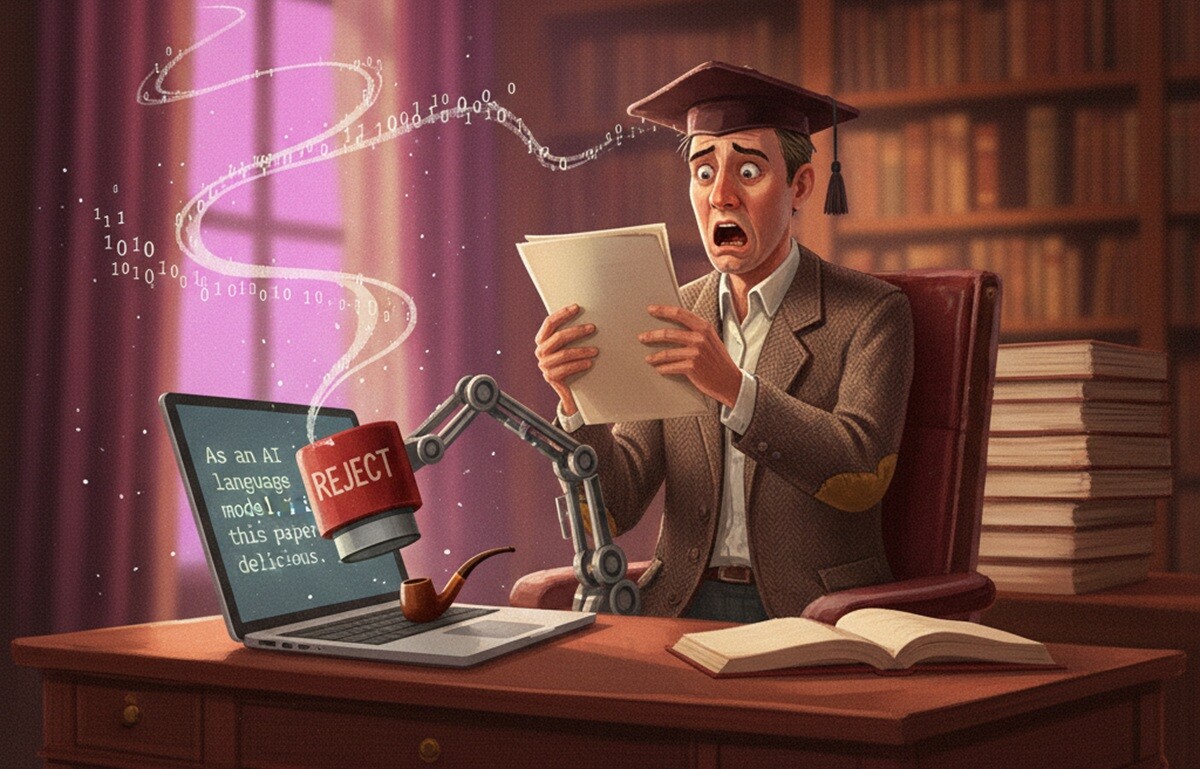

Текущий этап рецензирования для крупной конференции по ИИ вскрыл системные проблемы научного сообщества. Исследователи из элитных университетов изобретают AI-генерируемые источники, а разочарованные авторы отзывают свои работы, потому что рецензенты больше не читают статьи, а поручают ИИ писать критические отзывы.

Кризис доверия в научном рецензировании

Подготовка к предстоящей Международной конференции по представлениям обучения (ICLR) 2026 демонстрирует трещины в системе академического рецензирования. Публикации на Reddit и дискуссии на платформе OpenReview показывают, как генеративный ИИ подрывает доверие к исследованиям с обеих сторон: авторы выдумывают источники, а рецензенты доверяют ИИ написание отчетов. Исследование 2024 года добавляет критический контекст, показывая, что эти инциденты отражают глубокое структурное давление, а не простую лень.

Один из показательных случаев на стороне авторов — работа «BrainMIND» от исследователей из Технологического института Джорджии и китайского университета Цинхуа. Исследование обещало интерпретируемое картирование мозговой активности, но развалилось после того, как рецензенты обнаружили многочисленные фальшивые цитаты. Список литературы содержал полностью сфабрикованные названия и заглушки вроде «Jane Doe» в качестве соавторов. Рецензент отметил очевидное использование языковой модели и рекомендовал «решительный отказ». Авторы пересмотрели рукопись и ссылки, но всплыли дополнительные ошибки, что привело к полному отзыву статьи.

В другом случае авторы работы «Efficient Fine‑Tuning of Quantized Models via Adaptive Rank and Bitwidth» отозвали свою заявку в знак протеста после получения четырех отказов. Они обвинили рецензентов в использовании ИИ-инструментов для генерации отзывов без прочтения статьи. В рецензиях упоминались отсутствующие эксперименты, такие как бенчмарки GSM8K, и неуказанные методы, которые, по словам авторов, были четко описаны как в основном тексте, так и в приложении. В своем заявлении об отзыве они назвали это поведение «позорным осквернением священного долга рецензента» и осудили то, что они охарактеризовали как AI-индуцированную лень рецензентов.

Научное сообщество само создало эту проблему. Когда система рецензирования превращается в гонку за публикациями любой ценой, ИИ становится не инструментом помощи, а костылем для лени. Настоящая трагедия не в том, что машины пишут рецензии, а в том, что люди перестали проверять их работу. Мы наблюдаем классический случай, когда технологическое решение усугубляет системную проблему вместо ее решения.

Системное давление за академическими нарушениями

Эти инциденты отражают более глубокие структурные проблемы, выходящие далеко за рамки отдельных статей. Исследование в журнале Research Ethics Синьцюй Чжана и Пэн Вана анализирует, как государственные программы вроде китайской инициативы «Двойной первый класс» создают токсичные системы стимулов в ведущих университетах.

Исследователи описывают механизм, который они называют cengceng jiama — постепенное усиление давления через слои академической бюрократии. Национальные политики устанавливают расплывчатые цели вроде достижения «мирового уровня». Руководители университетов интерпретируют их как целевые показатели рейтингов и передают их в виде строгих квот на публикации. Деканы факультетов, обеспокоенные выполнением ожиданий, ужесточают их еще больше. То, что начинается как поощрение исследовательской продуктивности, часто заканчивается обязательными квотами на публикации в журналах SCI.

По словам Чжана и Вана, это создает то, что они называют «разделением целей и средств». Чтобы соответствовать нереалистичным требованиям продуктивности, исследователи отделяют свою работу от этических стандартов. Исследование документирует случаи, когда молодые ученые признавались, что у них «не было выбора», кроме как фальсифицировать данные или нанимать «призрачных писателей», чтобы сохранить свои позиции в среде «публикуйся или умри». Они также ссылаются на данные издателя Hindawi, который в 2023 году отозвал более 9600 статей — около 8200 из них были написаны в соавторстве с исследователями из Китая.

Возможно, наиболее тревожным является то, как сами академические учреждения реагируют. Чтобы избежать ущерба своей внешней репутации или потери позиций в рейтингах, администраторы университетов часто терпят неэтичное поведение, пока результаты выглядят хорошо. Один декан, процитированный в исследовании, привел китайскую пословицу: «Там, где вода слишком чистая, нет рыбы». Нельзя быть слишком строгим в наказании за проступки, так как это ухудшит эффективность исследований. Стратегия часто такова: превратить большие проблемы в маленькие и игнорировать маленькие — пока скандал не станет публичным.

По материалам The Decoder.