Anthropic заявила о решении проблемы памяти ИИ-агентов для долгой работы

Проблема кратковременной памяти у AI-агентов, которые забывают инструкции и контекст при длительной работе, остаётся одним из ключевых барьеров для их промышленного внедрения. Компания Anthropic утверждает, что нашла для этого решение в рамках своего Claude Agent SDK, представив двухэтапный подход, который позволяет агенту эффективно работать в рамках нескольких сессий.

В своей статье в блоге инженеры компании описали, как заставить агента, основанного на модели с ограниченным контекстным окном, выполнять сложные проекты, требующие большего времени.

Суть проблемы с памятью агентов

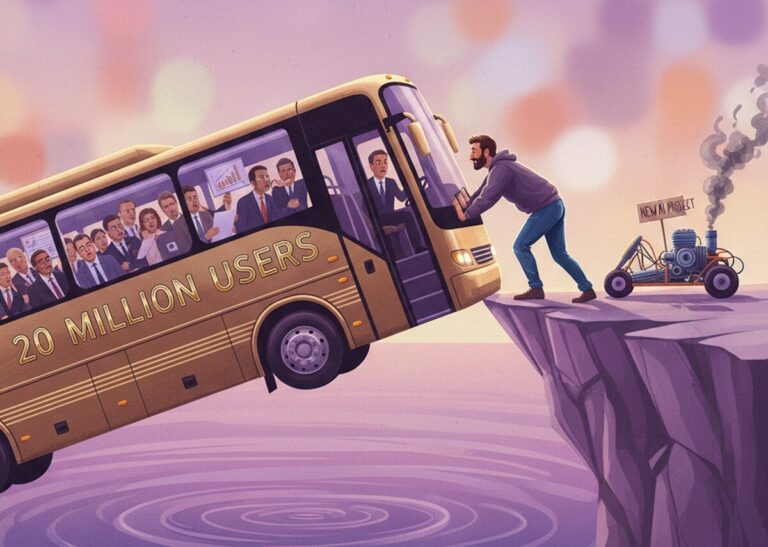

Агенты, построенные на базе больших языковых моделей (LLM), фундаментально ограничены размером их контекстного окна. Хотя эти окна постоянно растут, для долгоживущих задач, таких как разработка приложения, этого недостаточно. Агент начинает «забывать» предыдущие шаги, что может приводить к абсурдному поведению или полной остановке. Потребность в устойчивой памяти стала критичной для создания предсказуемых и безопасных для бизнеса агентов.

Рынок уже отреагировал на этот вызов. За последний год появилось несколько решений, пытающихся преодолеть этот разрыв:

- LangMem SDK от LangChain.

- Сервис Memobase.

- Инициатива Swarm от OpenAI.

Исследования в этой области также бурно развиваются, предлагая такие фреймворки, как Memp или Nested Learning Paradigm от Google. Большинство из них являются открытыми и теоретически адаптируемыми под разные LLM. Подход Anthropic, однако, сфокусирован на улучшении собственного инструментария для Claude.

Как работает решение Anthropic

Инженеры Anthropic выявили два типичных сценария неудач при использовании Claude Agent SDK для сложных задач, например, для создания «клона claude.ai». Во-первых, агент пытался сделать слишком много за один раз, исчерпывая контекстное окно и оставляя следующую сессию в догадках. Во-вторых, увидев частично готовый проект, агент мог просто объявить работу завершённой.

Ответом стал двухкомпонентный дизайн агента, вдохновлённый практиками опытных разработчиков:

- Агент-инициализатор: настраивает среду выполнения, логирует выполненные действия и созданные файлы, закладывая основу для работы.

- Кодирующий агент: выполняет инкрементальный прогресс в каждой сессии, оставляя после себя структурированные артефакты и «чистые» инструкции для следующего запуска.

Исследователи также добавили в кодирующего агента инструменты для тестирования, что улучшило его способность находить и исправлять ошибки, неочевидные из самого кода.

Заявление о «решении» долгоживущей проблемы звучит громко, но по сути Anthropic предложила грамотную инженерную обвязку для своего SDK. Это не магическое расширение контекстного окна, а прагматичный пайплайн, который разбивает большую задачу на управляемые сессии с чёткими хенд-оффами. Ирония в том, что лучшим учителем для ИИ-агента оказался не другой ИИ, а стандартные практики человеческих разработчиков: планирование, логирование и модульное тестирование. Вопрос в том, насколько эта архитектура, оптимизированная под веб-разработку, окажется универсальной для научного моделирования или финансового анализа.

Что дальше?

Anthropic подчёркивает, что их подход — лишь один из возможных в решении проблемы долгоживущих агентов. Компания ещё не определила, что эффективнее: единый агент общего назначения или специализированная мульти-агентная система. Их демонстрация была сосредоточена на разработке веб-приложений, поэтому следующий логичный шаг — эксперименты по обобщению метода для других типов задач, таких как научные исследования или финансовое моделирование.

Пока индустрия ищет идеальную формулу памяти для агентов, решения вроде предложенного Anthropic делают их более пригодными для реальной работы здесь и сейчас, а не в отдалённом будущем.

По материалам VentureBeat.