Три принципа создания качественных данных для обучения LLM на примере MiniMax

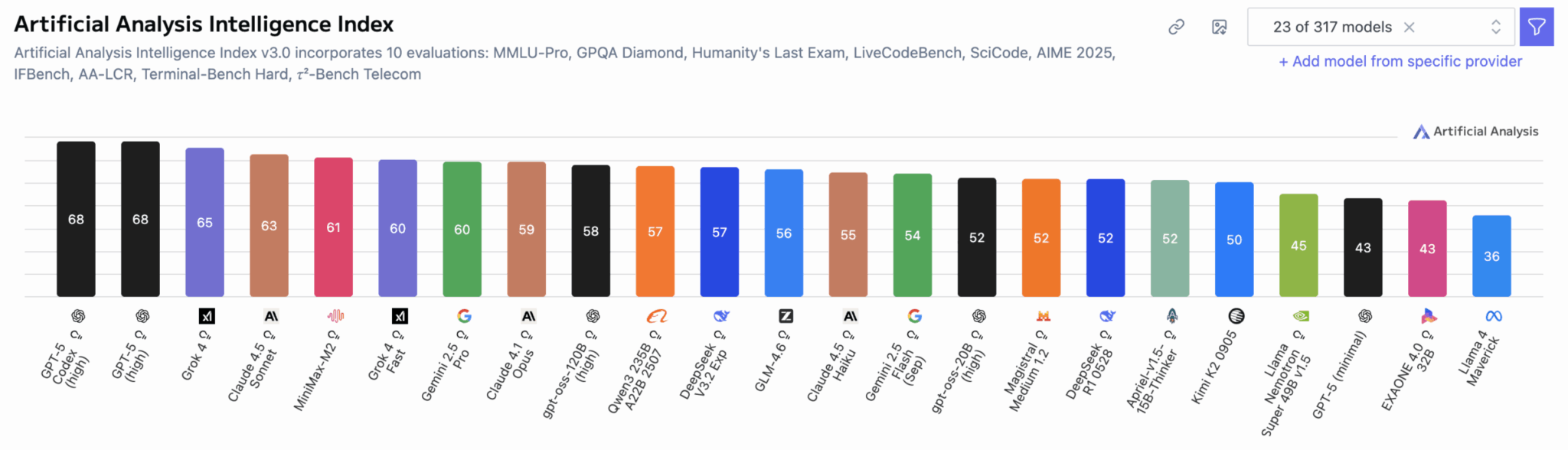

Исследователи из команды MiniMax AI поделились результатами работы над моделью MiniMax M2, которая заняла первое место среди открытых моделей и пятое среди всех моделей в бенчмарке Artificial Analysis. В центре внимания оказались принципы формирования обучающих данных для развития способности к рассуждениям.

Качество цепочек рассуждений и ответов

Логическая полнота без избыточной избыточности — ключевой критерий качества цепочек рассуждений (CoT). Слишком краткие объяснения приводят к пропуску шагов или излишней уверенности модели, что серьезно вредит финальной производительности и обобщению способностей.

Что касается ответов, большинство открытых работ переобучаются под конкретные паттерны бенчмарков ради лучших результатов в лидербордах. Хотя это эффективно для отдельных направлений данных, такая практика серьезно ограничивает обобщение возможностей универсальной модели.

При синтезе данных команда внедрила разнообразие форматов и наблюдала значительный прирост в экспериментах по многопрофильному слиянию. Для обработки потенциально проблемных случаев в CoT и ответах — таких как галлюцинации, ошибки следования инструкциям и логические ошибки — применялась очистка данных с использованием правил и LLM-as-a-judge.

Примечательно, что команда рассуждений состоит почти полностью из стажеров, что делает их достижения еще более впечатляющими. Ирония в том, что именно «сырые» данные требуют такой тонкой обработки, будто мы готовим изысканное блюдо из простых ингредиентов. Но результат говорит сам за себя — качество данных действительно становится новым нефтяным месторождением в машинном обучении.

Сложность и разнообразие распределения данных

Эксперименты подтвердили критическую важность математических и кодовых данных для улучшения способностей к рассуждениям. Эти два типа данных приносят пользу всем задачам, включая STEM и инструктивное выполнение.

Однако для полноценного охвата требуется достаточно разнообразные данные, покрывающие различные домены:

- Логические рассуждения

- Научные задачи

- Следование инструкциям

- Творческие задачи с открытым финалом

Разные домены требуют различных парадигм мышления, а разнообразие рассуждений служит основой для обобщения способностей. Также было замечено, что более сложные и комплексные запросы эффективнее для обучения моделей.

Масштабирование данных

Когда качество и разнообразие данных соответствуют стандартам, увеличение их объема последовательно приносит значительные улучшения. Практические подходы к масштабированию включают:

- Увеличение количества запросов

- Генерация нескольких ответов на один вопрос

- Многоэпохальное обучение

- Смешивание данных из разных направлений

На практике масштабирование данных — это инженерно-ориентированная проблема. Команда консолидировала все данные на основе характеристик задач, разделив их на два конвейера: верифицируемые и неверифицируемые задачи для автоматизированного синтеза и обработки данных.

Перспективные направления

Будущая работа сосредоточена на двух направлениях: составные способности (например, знание + рассуждение) и усиление задач рассуждения с помощью инструментов в сценариях агентов, а также интеграция верифицируемых и неверифицируемых задач, включая слияние CoT из разных доменов и обобщение способностей к рассуждениям.

По материалам Hugging Face.